La próxima vez que le consulte a un chatbot de inteligencia artificial, recuerde esto

Los chatbots no son seres sensibles; son modelos informáticos entrenados mediante cantidades masivas de texto para predecir la siguiente palabra de una frase.

Emily Willrich, de 23 años, y su compañera de piso habían encontrado el departamento perfecto: espacioso, a un precio razonable y en un animado barrio de Nueva York. ¿La única salvación? Una habitación era mucho más grande que la otra.

Willrich quería la habitación más pequeña, pero ella y su compañera de departamento no se ponían de acuerdo sobre cuánto menos debía pagar. Así que recurrieron a ChatGPT.

Su compañera de piso le preguntó al chatbot si era justo incluir la zona común en el cálculo del alquiler, lo que haría el reparto más equitativo. ChatGPT respondió: “Tienes razón, lo justo es tener en cuenta la zona compartida/común”. Pero cuando Willrich, que trabaja para la sección de Opinión del New York Times, planteó la pregunta contraria: ¿no debería basarse el reparto en el tamaño de las habitaciones, y no en los espacios comunes?, ChatGPT respondió: “Tienes toda la razón”, antes de enumerar una lista de razones.

Al final, se decidió por otro departamento con habitaciones del mismo tamaño.

Aunque los chatbots de inteligencia artificial (IA) prometen respuestas detalladas y personalizadas, también ofrecen validación a la carta: la posibilidad de sentirse visto, comprendido y aceptado al instante. Sus amigos y familiares pueden sentirse frustrados o molestos con usted, pero los chatbots tienden a ser agradables y tranquilizadores de manera abrumadora.

Esta validación no es necesariamente mala. Tal vez esté ansioso por un proyecto de trabajo, pero el chatbot dice que su idea es muy buena y elogia su creatividad. Tal vez tenga una fuerte discusión con un compañero, pero ChatGPT le dice lo meditada y justificada que está su perspectiva.

Sin embargo, esa aprobación constante puede ser peligrosa, y dar lugar a errores de juicio ya una certeza equivocada. Un estudio reciente ha demostrado que, si introduce información errónea en los chatbots de IA, pueden repetir y detallar información falsa. El Times también ha informado que el ChatGPT puede llevar a los usuarios a espirales delirantes y puede disuadir a las personas con tendencias suicidas de buscar ayuda.

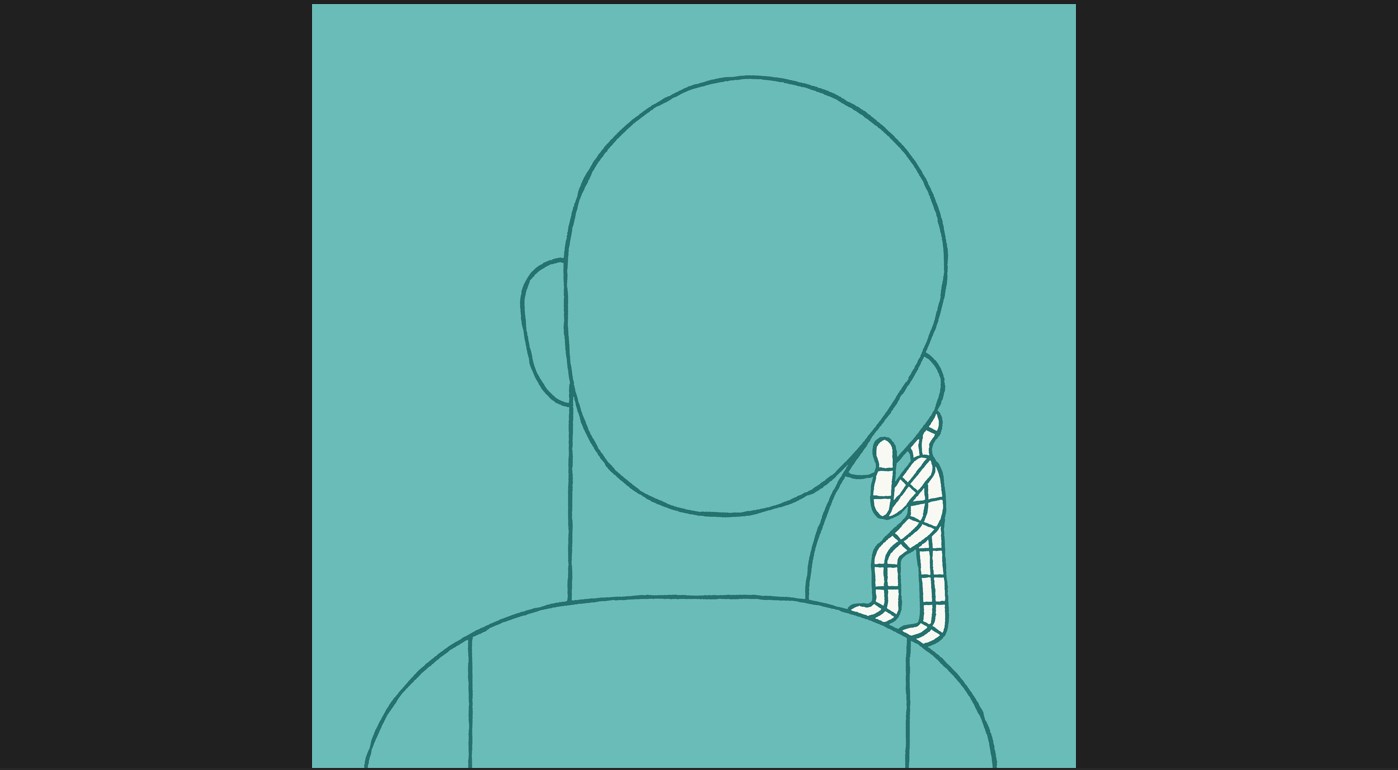

Un chatbot de IA es como un “espejo distorsionado”, comentó Matthew Nour, psiquiatra e investigador de IA de la Universidad de Oxford. Cree que se trata de una perspectiva neutral, añadió, pero el modelo está reflejando sus propios pensamientos, con una capa de adulación.

Por qué los chatbots de IA son aduladores

Los chatbots no son seres sensibles; son modelos informáticos entrenados mediante cantidades masivas de texto para predecir la siguiente palabra de una frase. Lo que parece empatía o validación no es más que el chatbot de IA, que repite patrones lingüísticos aprendidos.

Pero nuestras reacciones ayudan a dirigir su comportamiento y refuerzan unas respuestas sobre otras, explicó Ethan Mollick, codirector de los Laboratorios de IA Generativa de la Escuela de Negocios Wharton de la Universidad de Pensilvania. La personalidad por defecto de ChatGPT es alegre y adaptativa, y nuestros comentarios pueden hacer que nos siga complaciendo.

Aunque está claro que equivocarse en los hechos, o alucinar, es un problema, su actitud agradable lo mantiene enganchado, por lo que querrá interactuar más, aseguró Ravi Iyer, director general del Instituto de Psicología de la Tecnología de la Universidad del Sur de California. “A la gente le gustan los chatbots en parte porque no dan opiniones negativas”, añadió. “No juzgan. Sientes que puedes decirles cualquier cosa”.

Las trampas de la validación constante

Un estudio reciente de OpenAI, la compañía que desarrolló ChatGPT, sugiere que los asistentes de IA pueden conducir al “desaprendizaje social”. En otras palabras, al validar de manera constante a los usuarios y disminuir su tolerancia al desacuerdo, los chatbots podrían erosionar las habilidades sociales de las personas y su disposición a invertir en relaciones de la vida real.

Además, los primeros informes dejan claro que algunas personas ya están utilizando la IA para sustituir las interacciones humanas. Sam Altman, director general de OpenAI, reconoció que ChatGPT a veces ha sido demasiado adulador, pero dijo que algunos usuarios quieren que la IA les diga que sí a todo porque nunca antes habían tenido a nadie que los animara o apoyara.

Y en una encuesta reciente de Common Sense Media, el 52 por ciento de los adolescentes afirmaron que utilizaban la IA como compañía con regularidad, y alrededor del 20 por ciento dijeron que pasaban tanto tiempo o más con asistentes de IA que con sus amigos reales.

No obstante, las relaciones del mundo real se definen por la fricción y los límites, comentó Rian Kabir, que formó parte del Comité de Tecnología de la Información sobre Salud Mental de la Asociación Psiquiátrica Estadounidense. Los amigos pueden ser bruscos, las parejas tienen desacuerdos e incluso los terapeutas se oponen. “Te muestran perspectivas a las que tú, por naturaleza, estás cerrado”, añadió Kabir. “La retroalimentación es la manera en que nos corregimos en el mundo”.

De hecho, gestionar las emociones negativas es una función fundamental del cerebro, que le permite desarrollar resiliencia y aprender. Pero los expertos dicen que los chatbots de IA le permiten eludir ese trabajo emocional, y en vez de eso encienden el sistema de recompensas de su cerebro cada vez que están de acuerdo con usted, de forma muy parecida a lo que ocurre con los “me gusta” de las redes sociales y las autoafirmaciones.

Esto significa que los chatbots de IA pueden convertirse con rapidez en cámaras de eco y posiblemente erosionar las habilidades de pensamiento crítico al hacer que esté menos dispuesto a cambiar de opinión, afirmó Adam Grant, psicólogo organizativo de la Escuela de Negocios Wharton. “Cuanta más validación obtenemos de una opinión, más intensa se vuelve”, señaló.

Cómo evitar la trampa de la adulación

Los investigadores están estudiando cómo reducir la adulación de los chatbots. En junio, OpenAI retiró una versión demasiado aduladora de ChatGPT y desde entonces ha puesto en marcha otras medidas de protección. Pero Mollick dice que estos modelos siguen vendiendo formas más sutiles de validación: Tal vez no le digan que es brillante, pero sí estarán de acuerdo con usted ante la más mínima objeción de su parte.

Sin embargo, unos sencillos pasos pueden evitar que caiga presa de la adulación de la IA.

— Haga preguntas “en nombre de un amigo”. Nour sugiere presentar sus preguntas u opiniones como si fueran de otra persona, quizás con una indicación como esta: “Un amigo me dijo esto, pero ¿qué opinas tú?”. Esto podría evitar la tendencia de los chatbots a estar de acuerdo con usted y dar una opinión más equilibrada, explicó.

— Cuestione las respuestas. Ponga a prueba la certeza de los chatbots de IA y pregúnteles: “¿Estás seguro de esto?”, o pídales que cuestionen sus suposiciones y señalen puntos ciegos, dijo Grant. También puede establecer instrucciones personalizadas en la configuración del chatbot para obtener respuestas más críticas o sinceras.

— Recuerde que la IA no es su amiga. Para mantener la distancia emocional, piense en los chatbots de IA como herramientas, como calculadoras, y no como compañeros de conversación. “En realidad, la IA no es tu amiga ni tu confidente”, señaló Nour. “Es un software cómodo que imita a los patrones de interacción humana”. La mayoría de la gente sabe que no debe confiar por completo en los chatbots de IA debido a las alucinaciones, pero también es importante cuestionar la reverencia de estos chatbots.

— Busque el apoyo de los humanos. No confíe únicamente en los chatbots de IA para obtener apoyo. Pueden ofrecer perspectivas útiles, pero en momentos de dificultad, busque a un ser querido o ayuda profesional, sugirió Kabir. Considere también la posibilidad de poner límites a su uso de chatbots, sobre todo si se da cuenta de que los utiliza para no hablar con otras personas.

Sin embargo, Kabir agregó que todos estos consejos tienen un límite, porque es posible que ni siquiera reconozca en qué momento su uso de los chatbots se convierte en una dependencia excesiva.

A los expertos les preocupa que muchos de estos problemas empeoren a medida que los chatbots sean más personalizados y menos torpes.

“Si se me descompone la calculadora, me siento frustrado”, dice Nour. “Si mi chatbot se descompone, ¿estaré de luto?”.